Что такое индексация сайта

Содержание:

- Особенности индексирования сайтов с разными технологиями

- Как проверить индексацию

- Как подготовить сайт к индексации?

- Robots.txt

- Добавляем сайт в поиск Яндекса

- Дублирование

- Два пути индексации сайта

- Пошаговая инструкция по настройке индексации

- Зачем нужна индексация?

- Способы быстрой индексации сайта

- Типы роботов поисковых систем

- Проверка индексации страниц сайта через поиск

- Почему не индексируется сайт?

- «Яндекс» и Google не знает о вашем сайте

- Сайт или страницы закрыты от индексации в файле robots.txt

- Настройки приватности

- Сайт закрыт от поисковых роботов в мета-тегах

- Ошибки сканирования

- Сайт закрыт от роботов в .htaccess

- Нестабильная работа сервера или хостинга

- Проблемы с индексацией AJAX/JavaScript

- Дубли контента внутри сайта

- Плохая скорость загрузки

- Домен с баном

- Отсутствует sitemap

Особенности индексирования сайтов с разными технологиями

Ajax

Сегодня все чаще встречаются JS-сайты с динамическим контентом ― они быстро загружаются и удобны для пользователей. Одно из основных отличий таких сайтов на AJAX — все содержимое подгружается одним сплошным скриптом, без разделения на страницы с URL. Вместо этого ― страницы с хештегом #, которые не индексируются поисковиками. Как следствие — вместо URL типа https://mywebsite.ru/#example поисковый робот обращается к https://mywebsite.ru. И так для каждого найденного URL с #.

В этом и кроется сложность для поисковых роботов, потому что они просто не могут «считать» весь контент сайта. Для поисковиков хороший сайт ― это текст, который они могут просканировать, а не интерактивное веб-приложение, которое игнорирует природу привычных нам веб-страниц с URL.

Буквально пять лет назад сеошники могли только мечтать о том, чтобы продвинуть такой сайт в поиске. Но все меняется. Уже сейчас в справочной информации и Google, и Яндекс есть данные о том, что нужно для индексации AJAX-сайтов и как избежать ошибок в этом процессе.

Сайты на AJAX с 2019 года рендерятся Google напрямую — это значит, что поисковые роботы сканируют и обрабатывают #! URL как есть, имитируя поведение человека. Поэтому вебмастерам больше не нужно прописывать HTML-версию страницы.

Но здесь важно проверить, не закрыты ли скрипты со стилями в вашем robots.txt. Если они закрыты, обязательно откройте их для индексирования поисковыми роботам

Для этого в robots.txt нужно добавить такие команды:

Поисковые роботы Яндекса тоже могут индексировать сайты на AJAX, но при одном условии ― если у каждой страницы сайта есть HTML-версия. В справочнике Яндекса можно узнать подробнее, как сообщить роботу об HTML-версии страницы.

Флеш-контент

С помощью технологии Flash, которая принадлежит компании Adobe, на страницах сайта можно создавать интерактивный контент с анимацией и звуком. За 20 лет своего развития у технологии было выявлено массу недостатков, включая большую нагрузку на процессор, ошибки в работе флеш-плеера и ошибки в индексировании контента поисковиками.

В 2019 году Google перестал индексировать флеш-контент, ознаменовав тем самым конец целой эпохи. Поисковые роботы Яндекса индексируют только тот текст во Flash-документах, который размещен в таких блоках: DefineText; DefineText2; DefineEditText; Metadata.

Поэтому не удивительно, что поисковики предлагают не использовать Flash на ваших сайтах. Если же дизайн сайта выполнен с применением этой технологии, сделайте и текстовую версию сайта. Она будет полезна как пользователям, у которых не установлена совсем или установлена устаревшая программа отображения Flash, пользователям мобильных устройств (они не отображают flash-контент), так и поисковым роботам Яндекса.

Фреймы

Фрейм это HTML-документ, который не содержит собственного контента, а состоит из разных областей ― каждая с отдельной веб-страницей. Также у него отсутствует элемент BODY.

Как результат, поисковым роботам просто негде искать полезный контент для сканирования. Страницы с фреймами индексируются очень медленно и с ошибками.

Вот что известно от самих поисковиков: Яндекс индексирует контент внутри тегов <frameset> и <frame> и не индексирует документы, подгружаемые в тег <iframe>. А вот Google может индексировать контент внутри встроенного фрейма iframe. Именно iframe поддерживается современными технологиями, так как он позволяет встраивать фреймы на страницы без применения тега <iframe>.

А вот теги <frame>, <noframes>, <frameset> устарели и уже не поддерживаются в HTML5, поэтому и не рекомендуется использовать их на сайтах. Ведь даже если страницы с фреймами будут проиндексированы, то трудностей в их продвижении вам все равно не избежать.

Как проверить индексацию

Проверка видимости документов html осуществляется по-разному для Google и Яндекс. Но в целом не представляет собой ничего сложного. Сделать это сможет даже новичок.

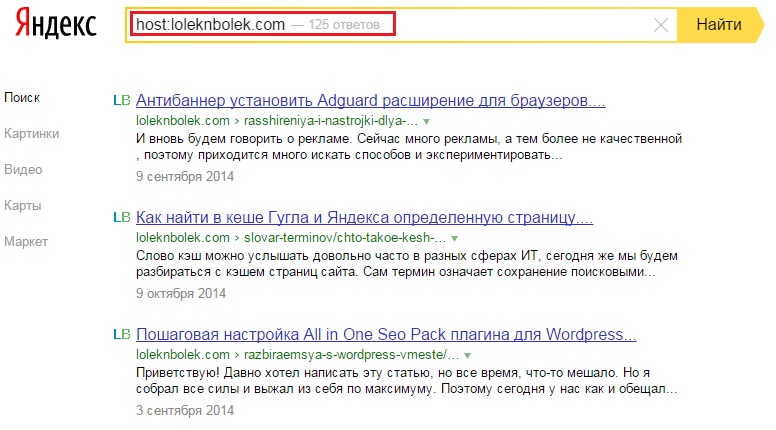

Проверка в Яндекс

Система предлагает три основных оператора, позволяющих проверить, сколько html-документов находится в индексе.

Оператор «site:» – показывает абсолютно все страницы ресурса, которые уже попали в базу данных.

Вводится в строку поиска следующим образом: site:znet.ru

Оператор «host:» – позволяет увидеть проиндексированные страницы с доменов и поддоменов в рамках хостинга.

Вводится в строку поиска следующим образом: host:znet.ru

Оператор «url:» – показывает конкретную запрашиваемую страницу.

Вводится в строку поиска следующим образом: url:znet.ru/obo-mne

Проверка индексации этими командами всегда дает точные результаты и является самым простым способом анализа видимости ресурса.

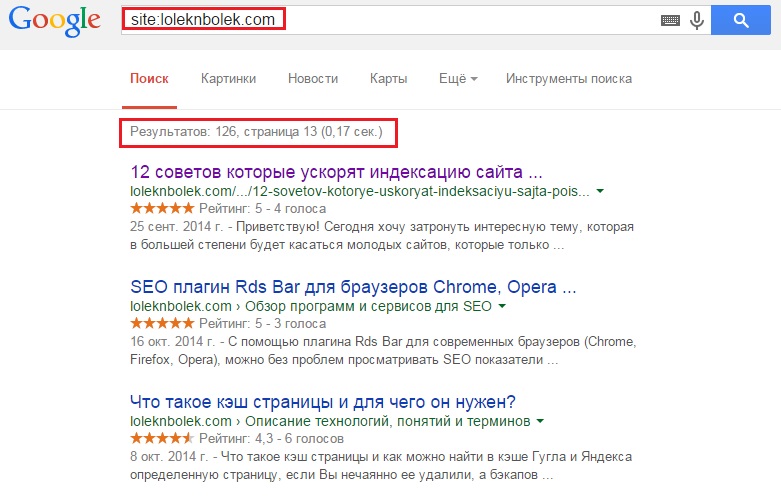

Проверка в Google

ПС Гугл позволяет проверить видимость сайта только по одной команде вида site:znet.ru.

Но у Google есть одна особенность: он по-разному обрабатывает команду с введенными www и без. Яндекс же такого различия не делает и дает абсолютно одинаковые результаты, что с прописанными www, что без них.

Проверка операторами — это самый «дедовский» способ, но я для этих целей пользуюсь плагином для браузера RDS Bar.

Проверка с помощью Webmaster

В сервисах Google Webmaster и Yandex Webmaster также можно посмотреть, сколько страниц находится в базе данных ПС. Для этого нужно быть зарегистрированным в этих системах и внести в них свой сайт. Попасть в них можно по ссылкам:

http://webmaster.yandex.ru/ — для Яндекс.

https://www.google.com/webmasters/ — для Google.

В Яндекс Вебмастере при нажатии на ссылку «Мои сайты» в левом боковом меню появятся все необходимые пункты для проверки не только количества страниц, но и многих других полезных и важных данных, в том числе и истории индексации.

Массовая проверка страниц на индексацию

Если вы ведете файл семантики по моей схеме, то проверить все страницы на индексацию для вас — дело трех минут.

- Заходим в файл распределения

- Выделяем все урлы в столбце URL

- Вкладка «Данные» — «Удалить дубликаты», таким образом останется список всех продвигаемых страниц

- Массово проверяем страницы на индексацию через Comparser. Можно и с помощью браузерного плагина Winka – он умеет работать со списком ссылок в отрыве от Сапы (вызвать меню плагина – проверка списка ссылок).

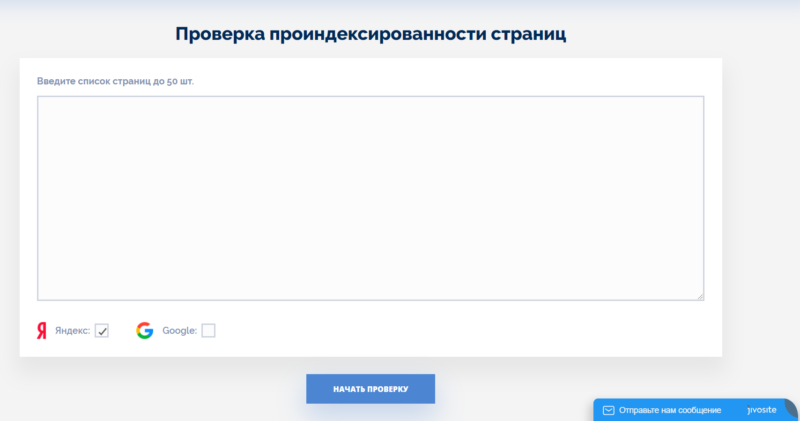

Сервисы вроде Serphunt

Сейчас я проверяю индексацию в основном здесь: https://serphunt.ru/indexing/, потому что у них можно сразу 50 урлов проверить и причем не только в яндексе, но и в гугле. Мало где можно проверить одновременно в обеих ПС на халяву сразу 50 урлов.

Суть такая — просто вбиваете адреса страниц, и сервис вам выдаёт результаты:

Проверяет не очень быстро — там надо будет подождать минуты 3, но к бесплатному инструменту и претензий немного. Просто в фоновом окне ставьте и занимайтесь своими делами, через несколько минут результаты будут готовы.

Как подготовить сайт к индексации?

Сразу стоит отметить, что крайне нежелательно выкладывать сайт на стадии разработки. Поисковые системы могут проиндексировать неоконченные страницы с некорректными сведениями, орфографическими ошибками и т. д. В итоге это негативно отразится на рейтинге сайта и выдаче информации с этого ресурса в поиске.

Теперь давайте перечислим моменты, о которых нельзя забывать на этапе подготовки ресурса к индексации:

- на flash файлы распространяются ограничения индексации, поэтому сайт лучше создавать с помощью HTML;

- такой тип данных, как Java Script также не индексируется поисковыми роботам, в связи с этим навигацию по сайту следует дублировать текстовыми ссылками, а всю важную информацию, которая должна быть проиндексирована, не пишем в Java Script;

- нужно убрать все неработающие внутренние ссылки так, чтобы каждая ссылка вела на реальную страницу вашего ресурса;

- структура сайта должна позволять с легкостью переходить от нижних страниц к главной и обратно;

- лишние и второстепенные сведения и блоки лучше переместить к низу страницы, а также скрыть их от ботов специальными тегами.

Robots.txt

Это файл, который можно отредактировать в любом текстовом редакторе. Преимущество и одновременно необходимость состоим в том, что он прописывает строгие инструкции для роботов поиска различных поисковых систем. Располагают роботс.тхт в корневой папке сайта.

Наиболее популярные ошибки, возникающие при работе с данным файлом:

-

закрытие действительно нужных страниц сайта. Чаще всего эта ошибка связана с незнанием всех аспектов и нюансов правильного заполнения;

-

использование кириллических символов в файле не допускается;

-

одни и те же правила для разных роботов. Нюанс, о котором часто забывают. Согласитесь, что даже на вид «Яндекс» и «Google» сильно отличаются друг от друга. Что тогда говорить о внутренних алгоритмах ранжирования и поисковых роботах?! Соответственно, и правила надо прописывать разные, так как один бот их примет, а другой даже не обратит внимания, а может и сразу уйдет, не завершив процесс индексирования.

-

использование директивы «crawl-delay» (определяет частоту запросов поискового бота и часто используется в тех случаях, когда сервер подвержен сильной нагрузке) без необходимости. Реальный пример: был сайт-визитка на самом дешевом хостинге. В него добавили каталог, содержащий около 10 000 товаров. Робот-поисковик начал скачивать и анализировать информацию и из-за ее объема стал не успевать ее обрабатывать. Многие страницы стали недоступны, выдавая 404-ую ошибку. Логичное решение – выставить директиву «crawl-delay». Поставили, все начало работать. Затем, в связи с разрастанием сайта, было решено перенести веб-ресурс на другой хостинг-провайдер, учтя при этом заранее параметры нагрузки сервера. Вроде все замечательно, а директиву «кроул» убрать забыли!!! В результате нагрузка на сервер минимальная, робот «не спешит» все обрабатывать и на выходе – очень долгое время индексации сайта.

Проверить файл с инструкциями для роботов можно, используя сервисы вебмастера от «Яндекс» или «Гугл». В «Yandex.Webmaster» достаточно зайти в раздел «Инструменты», затем в «анализ robots.txt». Загрузить файл и его вставить непосредственно в поле, посмотреть рекомендации или ошибки, которые необходимо будет исправить.

Добавляем сайт в поиск Яндекса

Чтобы страницы нового сайта начали отображаться в поиске Яндекса их также нужно добавить в индекс. Механика процесса идентична поисковой системе Google. Добавление ресурса в поиск осуществляют через консоль Яндекс.Вебмастер. При этом есть и другие способы (о них мы расскажем ниже), но наиболее рабочим считается именно этот. Возможности вебмастерки Яндекса в целом аналогичны Search Console. Более подробно об этом сервисе можно почитать здесь.

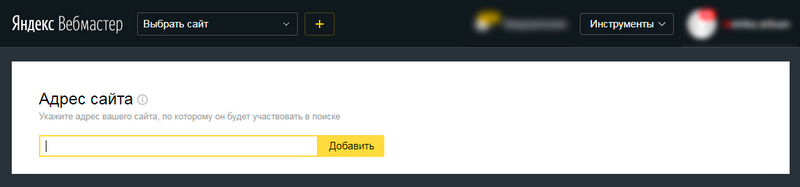

Добавление в Яндекс.Вебмастер и подтверждение прав на сайт

Для привязки сайта к вебмастерке понадобится учетная запись в Яндексе. Если она есть, что вероятнее всего, т.к. многие пользуются почтой и другими яндексовскими сервисами, переходим сюда и указываем адрес сайта.

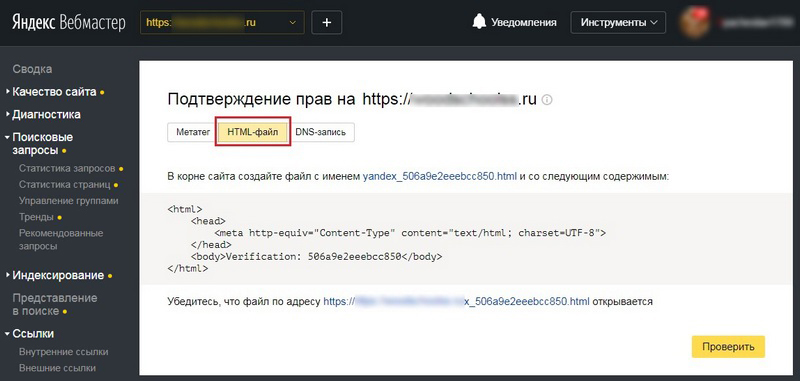

Как и в случае с гугловской консолью, дальше нужно пройти верификацию и подтвердить права. Сделать это можно по-разному:

- создав HTML-файл с уникальным идентификатором, и поместив его в корневой каталог сайта;

- разместив в HTML-коде главной страницы специальный метатег;

- добавив DNS-запись с идентификатором;

- подтвердив электронный адрес из WHOIS-записи (этот способ не рекомендуется даже самим Яндексом).

Для подтверждения прав удобнее всего использовать первый способ — через HTML-файл. Указав сайт и перейдя во вкладку, отмеченную на скриншоте, система сгенерирует файл с уникальным именем и содержимым. Его нужно скачать и разместить в корневом каталоге сайта. Далее проверяем, что файл открывается по указанной ссылке. Нажимаем кнопку «Проверить». Если все сделано правильно, панель инструментов слева станет кликабельной.

Добавляем сайт в индекс

После верификации и получения доступа к функционалу вебмастерки, выполняем следующие действия.

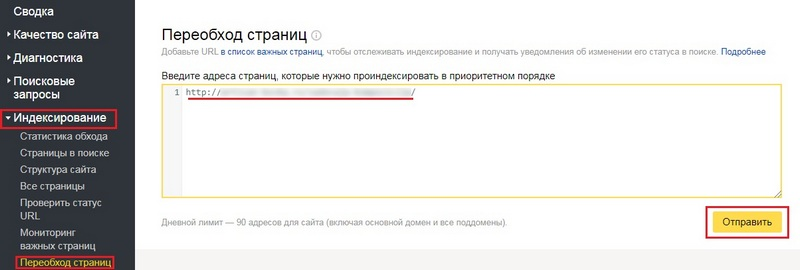

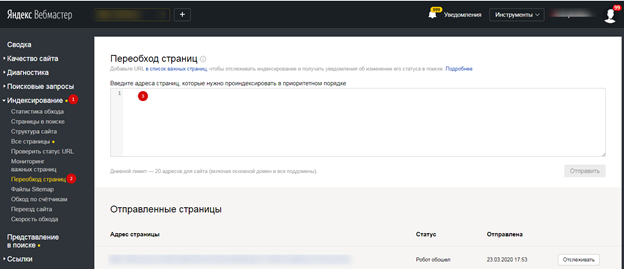

Переходим во вкладку «Индексирование» → «Переобход страниц»

Добавляем главную страницу и основные разделы сайта — нажимаем «Отправить»

Обратите внимание, в Яндексе установлен лимит на количество индексируемых страниц

Все новые страницы, которые в дальнейшем будут добавляться на сайт, отправляют на переиндексацию по аналогичной схеме.

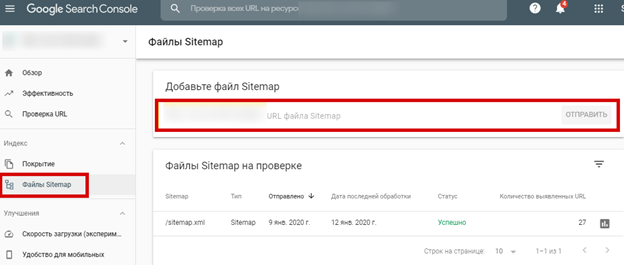

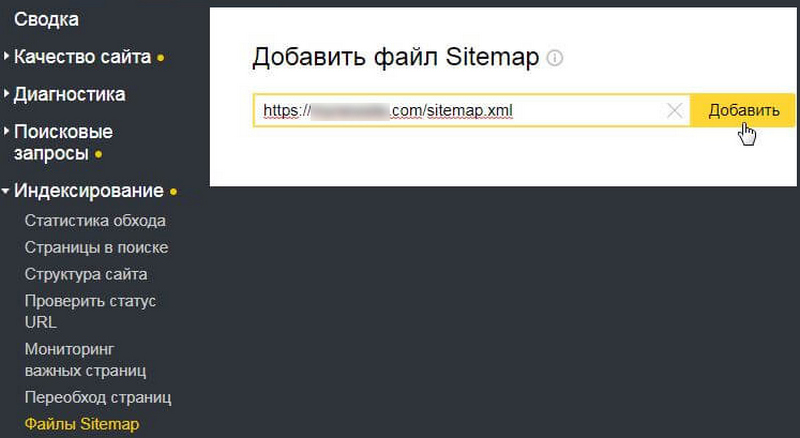

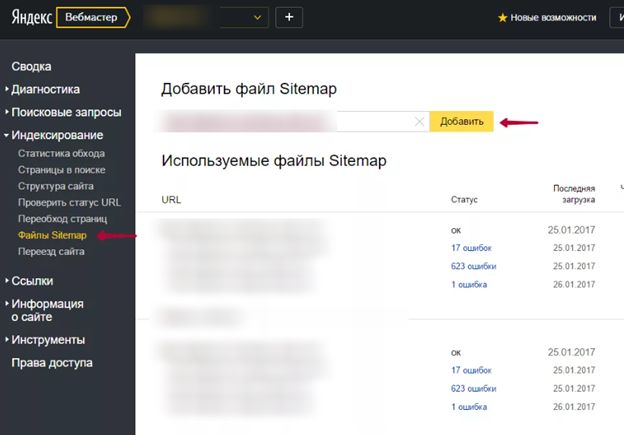

Дополнительно в Яндекс.Вебмастер необходимо добавить файл sitemap.xml. Здесь работает та же механика, что и в Google. Сначала необходимо создать саму карту. Если это сделано не через плагин — размещаем sitemap на сервере. Далее в разделе «Индексирование» → Файлы Sitemap вписываем в поле URL, по которому доступен файл. Нажимаем «Добавить».

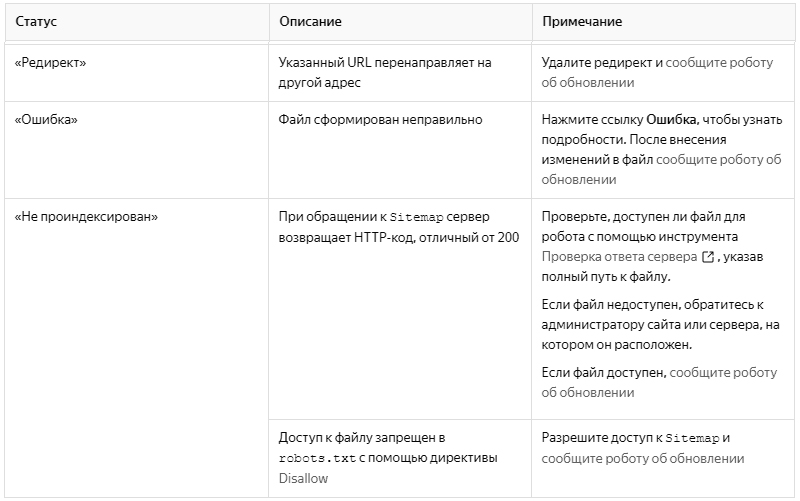

После добавления файл будет какое-то время обрабатываться. Это происходит не быстро, и может занять до двух недель. По завершении обработки напротив файлов должен отображаться статус «OK». Если присутствует статус «Редирект», «Ошибка» или «Не проиндексирован», необходимо определить причину некорректной индексации, исправить ее, после чего сообщить роботам об обновлении.

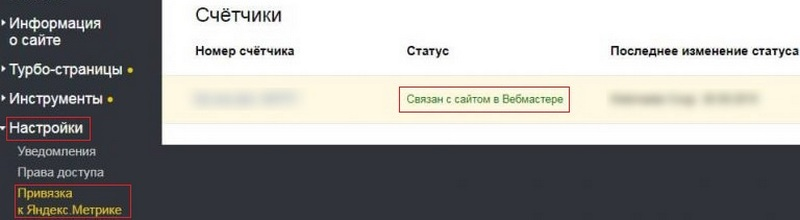

Индексируем страницы через Яндекс.Метрику

Существует еще один способ сообщить краулерам Яндекса о новых страницах сайта — через Метрику. Этот вариант менее удобен, чем первый, но знать о нем вебмастеру не помешает. Для этого на сайте должен быть добавлен и настроен счетчик Яндекс.Метрики. В любом случае рано или поздно его придется добавить, конечно, если вы намерены серьезно заниматься продвижением своего проекта.

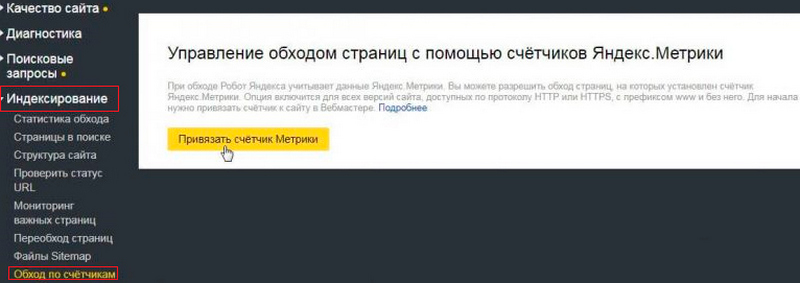

Итак, чтобы роботы Яндекса подтягивали сведения о новых страницах из данных Метрики, нужно разрешить обход страниц, на которых установлен счетчик. Для этого выполняем следующие действия.

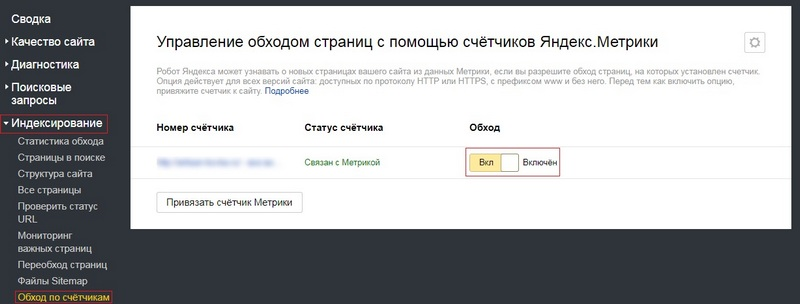

Активировав эту опцию, во вкладке Привязка к Яндекс.Метрике отобразится статус «Связан с сайтом в Вебмастере».

Дублирование

Подразумевает наличие нескольких идентичных страниц одного сайта, в которых содержится одинаковый контент.

Виды дублей:

-

страницы, адрес которых различается знаком «/». Например, «www.primer_saita.ru/Tovar/cart/GM928» и абсолютно аналогичный «…/GM928/». Часто встречается такая ситуация с карточкой одного и того же товара, которая относится к разным категориям (коньки, подходящие, как для девочек, так и для мальчиков);

-

дубли-страницы с незначащими параметрами, которые не воспринимает робот-поисковик. Примеры некоторых незначащих элементов для робота-поисковика, можно увидеть ниже:

Неприятности, которые могут возникнуть из-за дублей:

-

бот поисковой системы, вместо индексации необходимого и корректного адреса может посещать и анализировать множество ненужных страниц;

-

в базу данных поиска робот-анализатор может включить только одну страницу из всех возможных дублей, опираясь на свое усмотрение.

Как бороться с дублированными страницами:

Прописать атрибут rel= «canonical» тега со своим значением, то есть «выделить» страницу, расставив «приоритеты» цепочкой. Например, есть две страницы:

Допустим, что предпочитаемый адрес, который нам нужен – это вторая ссылка. Тогда, в первой странице необходимо прописать в ее html-коде следующую строчку:

Важно! Алгоритм анализа поисковым роботом устроен таким образом, что не считает данную директиву строгой, поэтому бот рассматривает ее, как предполагаемый вариант, который может быть проигнорирован!

-

«редирект 301», о котором мы уже говорили ранее. Особенно актуален в случаях дублей страниц с «/» и без него;

-

В файле robots.txt прописать параметры «disallow» (запрет доступа) и «clean-param» (учитывание динамических параметров (id сессий и др.), не влияющие на содержимое страницы). Пример таких дублей мы рассмотрели чуть ранее.

Где можно выявить дубли? Все в том же Вебмастере. В сервисе от «Яндекса» заходим в раздел «Индексирование», затем «Проверить статус URL», вводим ссылку, анализируем результат.

Два пути индексации сайта

Есть два пути, с помощью которых поисковая система узнает о новом ресурсе и начнется индексация сайта:

1

Для того чтобы сообщить поисковикам о новом ресурсе, нужно обязательно воспользоваться специальными сервисами для веб мастеров:

- Яндекс.Вебмастер (https://webmaster.yandex.ru/),

- Google Webmaster Tools (//www.google.com/webmasters/tools/),

- Webmaster.mail (https://webmaster.mail.ru/),

- Bing Webmaster Tools (https://www.bing.com/toolbox/webmaster),

- Nigma.ru.

2

Этот вариант рекомендован к использованию в большинстве случаев: просто получите некоторое количество внешних ссылок на ресурс и дожидайтесь прихода робота. Добавление сайта вручную в некоторых случаях даже удлиняет срок ожидания робота.

Как правило, первичная индексация сайта занимает от 2-3 дней до двух недель и это зависит от системы поиска.

Пошаговая инструкция по настройке индексации

Перед тем, как отправить сайт на индексацию поисковыми системами, необходимо произвести предварительную подготовку. Связано это с несколькими моментами:

- Грамотная предварительная работа исключит индексацию роботом поисковой системы лишней или не до конца оформленной и прописанной информации.

- При обнаружении роботом недочетов — непрописанных мета-данных, грамматических ошибок, незакрытых неинформативных ссылок — поисковая система ответит владельцу сайта низким рейтингом, некорректной подачей материала в выдаче и т.п.

- Пока производится подготовительная к демонстрации «поисковикам» работа, необходимо скрыть информацию от роботов и индексации соответствующей записью в файле robots.txt.

Правильная подготовка к индексации будет включать в себя:

1.Разработку мета-тегов, description и title страниц:

- Title должен содержать не более 60 знаков. Это основной заголовок страницы и самый важный из тегов.

- Description состоит из читабельных фраз, позиционирующих данную страницу, то есть необходимо прописать основные тезисы, о чем именно пойдет речь в данном материале.

- Тег keywords предполагает прописывание всех возможных слов по данному вопросу. В последнее время ценность этого тега уменьшилась в глазах поисковых систем, поисковых подсказок.

- Мета-тег revisit (или revisit-after) будет говорить о том сроке, когда планируются обновления сайта, это своего рода просьба-рекомендация оптимизатора для робота, указывающая оптимальный промежуток времени до следующей проверки ресурса.

2. Сокрытие внутренних и неинформативных разделов сайта. Производится эта робота также в файле robots.txt. «Поисковик» считает такого рода информацию «сорной», а потому это будет минусом в процессе проверки ресурса.

3. Необходимо также скрыть и ссылки на разделы служебного характера, которые расположены в содержимом сайта. Для этого используются команды noindex (для Яндекса) и nofollow (для всех «поисковиков»).

4. Незакрытые внешние ссылки на другие сайты могут привести к снижению веса сайта. Поэтому их тоже необходимо скрывать от роботов.

5. К выделению ключевых слов и основных моментов жирным необходимо относиться аккуратно, поскольку поисковая система расценивает эти слова как самые важные, что не всегда является так фактически.

6. Все имеющиеся изображения необходимо подписать тегом alt.

7. Необходимо проверить тексты на количество ключевых слов и оборотов в тексте, чтобы робот не проигнорировал информацию в связи с высоким показателем тошноты текста.

8. Обязательным пунктом перед подачей заявки в поисковые системы на индексацию ресурса является проверка орфографии, ошибок грамматического и стилистического характера. При наличии таковых в дескрипшн система выдаст информацию именно в таком виде, что может отсеять большой процент желающих посетить сайт еще на этапе выдачи по запросу.

Для того, чтобы ресурс вышел в числе других в выдаче по поисковому запросу пользователя, необходимо настроить индексацию в основных используемых поисковых системах:

2. Яндекс.Вебмастер:

Помимо индексации в основных системах, не стоит забывать и о чуть менее известных «поисковиках»:

- Рамблер ориентируется на индексацию ресурса в Яндексе, поэтому для добавления в его базу индекса достаточно пройти индексацию в основной поисковой системе.

- Индексацию в Mail.ru производят здесь: http://go.mail.ru/addurl

- Трафик русской поисковой системы Nigma.ru составляет около 3000000 в сутки. Подать заявку на индексацию в этой системе можно здесь: http://www.nigma.ru/index_menu.php?menu_element=add_site.

Зачем нужна индексация?

Индексация — очень важный процесс на этапе раскрутки сайта. Своевременно выполненная, она позволяет решить сразу несколько задач:

- занять достойное место в поисковиках;

- привлечь поисковый трафик на ресурс;

- привлечь партнеров для обмена ссылками, а магазинам – клиентов;

- улучшить поведенческий фактор (работает, если контент на сайте по-настоящему полезный, а не состоящий из абракадабры);

Кроме того, боты при индексации могут выявить нарушения правил действующих поисковиков и применить меры. Например, заблокировать ресурс или отправить его под фильтр, тем самым немного снизив конкуренцию в Сети.

Способы быстрой индексации сайта

Если добавить ваш новый веб-ресурс в поисковые системы, которые вы знаете, индексация сайта произойдет гораздо быстрей. Добавить в Yandex — https://webmaster.yandex.ru/addurl.xml, в Google — https://www.google.ru/intl/ru/addurl.html.

Нужно создать карту сайта. Зарегистрироваться в сервисах webmaster.yandex.ru и www.google.com/webmasters. Указать там ваш файл sitemap.xml.

Для ускорения индексации сайта вам поможет регистрация в социальных закладках и сетях (bobrdobr.ru, memori.ru, twitter.com, vkontakte.ru и др.). Там можно добавлять разные страницы вашего сайта.

Заведите свои блоги на my.ya.ru, blogspot.com, blogs.mail.ru, livejournal.com и др. Добавьте в них записи со ссылками на страницы вашего сайта. По мере возникновения новых страниц на сайте, для их быстрой индексации поисковиками, добавляйте ссылки в ваших блогах на эти страницы.

Стоит зарегистрироваться в нескольких популярных каталогах и рейтингах. К примеру, регистрация на LiveInternet и Рамблер ТОП100 способна ускорить индексацию сайта из-за того, что роботы довольно часто заглядывают в ТОПы.

Поисковые боты очень любят посещать популярные блоги с их комментариями. При этом роботы тщательно отслеживают все ссылки в блогах. Попробуйте посещать такие блоги и оставлять там ненавязчивые комментарии со ссылками. Старайтесь соблюдать правила блога и ссылки вставлять в специально отведенные для этого места во избежание удаления вашего комментария как спама.

Еще один похожий совет для ускорения индексации сайта — это комментарии на форумах с большой посещаемостью. Как раз на форумах, кстати, абсолютно не запрещено вставлять ссылки, если они имеют отношение к вашему ресурсу. Форумы посещаются ботами не хуже чем блоги.

Довольно трудоемкими, но популярными считаются способы быстрой индексации веб-ресурсов при помощи размещения на сторонних ресурсах большого количества статей со ссылками на ваш сайт. Трудоемкость заключается в написании огромного количества статей с интересным и актуальным содержанием. Эти статьи выполняют функцию, подобную каталогу ссылок.

Необходимо построить четкую и грамотную структуру сайта. Ее построение должно быть легким и удобным для работы поисковых роботов со страницами сайта. Достичь этого вовсе не трудно. Принцип заключается в том, чтобы ссылки на всех страницах сайта направляли посетителя с одной страницы на другую.

Если ваш проект содержит огромное количество страниц, то для быстрой индексации сайта следует обратить внимание на следующий метод. Робот поисковика считывает и анализирует информацию, постепенно передвигаясь по страницам сайта

При довольно значительном количестве страниц он может просто не добраться до части последних страниц, которые значительно удалены от главной. При этом индексация сайта в поисковых системах ухудшается.

Идеальной в таком случае является древообразная четкая структура карты вашего сайта, в которой каждому ответвлению будет соответствовать некоторый подраздел с меньшим количеством страниц. Каждая страница сайта, желательно, должна быть в удалении не более трех кликов от главной.

В случае, если отдельные страницы сайта поисковые роботы не проиндексировали, следует ссылки на эти страницы разбросать по сторонним ресурсам. При индексации сайтов с вашими ссылками робот обязательно посетит и ваши страницы.

Чтобы индексация сайта происходила быстрей, необходимо обеспечить более частое посещение роботами его страниц. Для достижения этого вам придется довольно часто обновлять страницы сайта и пополнять новой информацией

И самое важное при этом наполнять сайт статьями и текстами со стопроцентной уникальностью

Типы роботов поисковых систем

Процессы поисковых систем основаны на работе четырех типов основных поисковых роботов:

- Основной индексирующий робот;

- Робот, индексирующий изображения;

- Робот, изучающий зеркала сайта;

- Робот, контролирующий работоспособность страниц сайта и сайта в целом.

Вы можете контролировать, вернее, быть в курсе, какой робот зашел к вам на сайт. Для этого есть специальные лог-файлы посещений. Доступны эти файлы в административной панели сервера (хостинга) или по FTP. Например,

- Основной индексирующий робот Яндекс: YandexBot/3.0; +http://yandex.com/bots;

- Бот Mail: Mail.RU_Bot/2.0; +http://go.mail.ru/help/robots.

- В журнале посещений, вы увидите боты в таком обозначении: «Mozilla/5.0 (compatible; bingbot/2.0; +http://www.bing.com/bingbot.htm) – это бот Bing.

Кроме четырех перечисленных , выше, типов роботов, есть и другие индексирующие роботы:

- Индексирующие видео и иконки (пиктограммы) сайтов;

- Робот, контролирующий доступность (работоспособность) сайтов;

- Индексатор «быстрой» информации, на новостных площадках Яндекс. Новостей и т.п.

На этом все! Эта небольшая статья, не может охватить все детали, и процессы поисковых систем требует более глубокого изучения.

SeoJus.ru

Проверка индексации страниц сайта через поиск

Термином «индексация сайта» обозначают добавление ресурса или его материалов в базу данных поисковой системы. То есть, если страницы сайта проиндексированы, то при введении поискового запроса они окажутся в общей выдаче. Это именно то, чего добиваются вебмастера – чтобы материалы Интернет-ресурсов как можно быстрее оказались проиндексированы.

Чтобы быть уверенными в том, добавлен ли сайт в поисковую базу, выполняется проверка индексации сайта в Яндексе, Гугле и других поисковых системах. Эту проверку можно выполнять как ручным способом, так и автоматически.

Рассмотрим, как проверить проиндексирован ли сайт, используя при этом поисковый запрос. Здесь возможно несколько вариантов:

- Введение url конкретной страницы в поисковый запрос. Этот способ подойдет для тех страниц, которые проиндексированы не быстроботом Яндекса. В противном случае, страница может и не отобразиться, поэтому данный метод проверки малоэффективный.

- Введение части текста в поисковый запрос. Метод действует только тогда, когда текст уникальный. Для этого необходимо выделить часть текста (10-20 слов) и ввести их в поиск. Однако, материал будет достаточно поздно отображаться в выдаче. Этот способ также не очень эффективный и хлопотный.

- Использование расширенного поиска. Чтобы узнать, проиндексирован ли сайт в Яндексе, нужно ввести необходимый запрос в этом поисковике и выполнить поиск, после чего под строкой появится ссылка «Расширенный поиск». Что касается Гугла, то с ним немного дольше придется повозиться. После введения запроса с правой стороны появится знак шестеренки – «Настройки». Нужно нажать этот значок и в меню выбрать пункт «Расширенный поиск». Помимо Яндекса и Гугла другие ПС также располагают расширенным поиском. Итак, дальше нужно ввести фразу и домен, на котором нужно произвести поиск. В выдаче обычно самой первой должна появиться нужная статья. Это работает при условии, что материал уникальный. Можно пойти более быстрым путем и сразу вбить в расширенный поиск url страницы. Данный способ эффективный, но требует временных затрат. Следует учесть, что не всегда нужный адрес находится на первой позиции в поисковой выдаче. Иногда необходимо просмотреть всю первую страницу в выдаче, то есть, топ-10.

Почему не индексируется сайт?

Бывают ситуации, когда вебмастер ведет работу над SEO-оптимизацией сайта: активно наполняет его контентом, наращивает ссылки, а количество страниц в поисковой выдаче Google или «Яндекс» не увеличивается. Или что еще хуже — в поиске нет ни одного документа с сайта. С чем это связано? Самые распространенные причины:

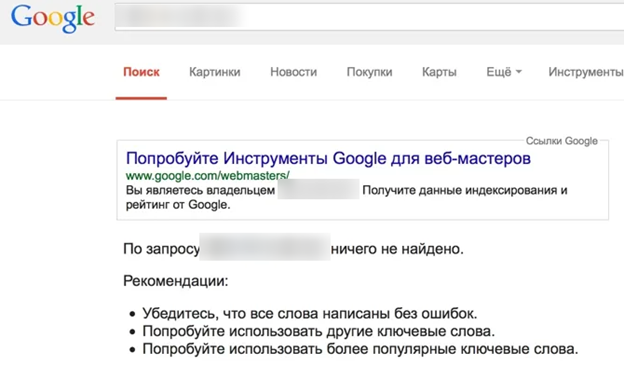

«Яндекс» и Google не знает о вашем сайте

Если это новый ресурс, и вы только недавно открыли его для поисковых роботов, то, возможно, они просто его еще не нашли. Но эту проблему легко решить, выполнив несколько простых манипуляций:

- Добавить сайт в «Яндекс.Вебмастер» и Google Webmasters.

- Направить поисковых роботов на страницы сайта.

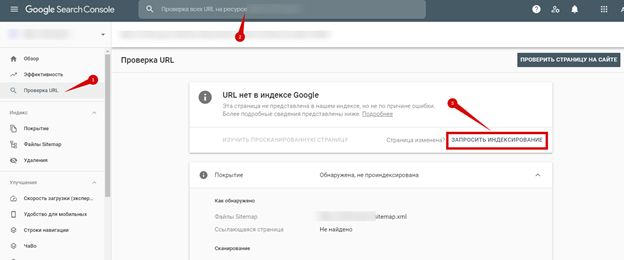

В «Яндекс.Вебмастер» («Индексирование» — «Переобход страниц»):

В Google Webmasters («Проверить URL» — Добавить адрес страницы — «Запросить Индексирование»):

Нужно будет немного подождать, пока робот обойдет страницы сайта. Как правило, на это уходит 1-2 часа (хотя может затянуться на несколько дней).

Сайт или страницы закрыты от индексации в файле robots.txt

Порой вебмастера, работая над сайтом, забывают открыть его для индексации. Но это легко исправить. Добавьте следующую команду в файл:

Это означает, что ресурс открыт для всех поисковых роботов. Но не забывайте, что нужно закрыть дубли на сайте, ведь не все содержимое должно принимать участие в поиске. Поэтому уделите заполнению файла robots.txt достаточно времени.

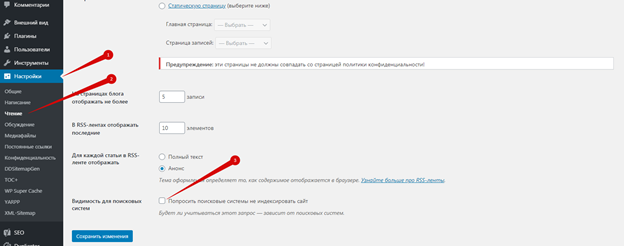

Настройки приватности

Если сайт управляется CMS WordPress, то по умолчанию в нем выставлены настройки приватности, которые запрещают индексацию поисковыми роботами. Авторизуйтесь в админке, перейдите в «Настройки — Чтение — Видимость для поисковых систем» и снимите галочку:

Сайт закрыт от поисковых роботов в мета-тегах

Запретить индексировать содержание страниц можно и с помощью мета-тега:

Как решить проблему:

- Посмотрите, нет ли такого тега на странице.

- Удалите код или добавьте другие мета-теги follow и index.

Ошибки сканирования

Проблемы с индексацией возникают и в том случае, если робот, обращаясь к ресурсу, не может просканировать его содержимое.

Проверьте все ли в порядке:

- Авторизуйтесь в Google Webmaster.

- Откройте «Сканирование» — «Ошибки сканирования»:

В идеале не должно быть никаких ошибок.

Сайт закрыт от роботов в .htaccess

В этом файле содержится правило 301 редиректа. Но помимо него, может быть прописана команда не индексировать сайт.

Чтобы проверить, выполните следующее:

- Найдите и откройте файл файл .htaccess на сервере.

- Проанализируйте содержимое кода.

Нестабильная работа сервера или хостинга

Выбирайте стабильный хостинг с хорошей репутацией. В противном случае, если роботы будут обращаться к сайту, он будет часто недоступен, а их попытки станут все реже. Через некоторое время они и вовсе откажутся заходить к вам на сайт.

Проблемы с индексацией AJAX/JavaScript

Поисковым роботам сложнее просканировать содержимое AJAX и JavaScript, чем HTML. Если вы допустите ошибки при оптимизации, то Google и «Яндекс» не проиндексируют определенные страницы или даже весь сайт.

Дубли контента внутри сайта

За дублирование контента поисковые системы наказывают санкциями, но это тоже одна из причин плохой индексации. К дублям может относиться одинаковый контент, открывающийся на разных страницах, мета-теги или даже страницы, если они доступны под двумя адресами (с www и без; http и https). Если не исправить проблему своевременно, то она негативно скажется на дальнейшем SEO-продвижении.

Плохая скорость загрузки

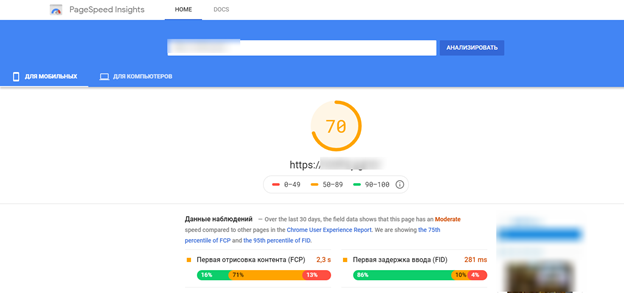

При плохой скорости загрузки ресурса, он может плохо индексироваться и потерять позиции, так как этот показатель относится к факторам ранжирования. Проверить насколько быстро загружается ваш сайт можно с помощью специального инструмента — Google Page Speed:

Поработайте над улучшением скорости загрузки сайта, учитывая рекомендации инструмента.

Домен с баном

Случается, что вебмастер выбирает и регистрирует созвучное имя для сайта, наполняет ресурс и ждет, когда он проиндексируется, но ничего не происходит. После анализа домена, выясняется, что домен ранее использовался и находится в бане поисковых систем.

Исправить такую ситуацию не просто. Придется написать в тех. поддержку «Яндекс», чтобы они пересмотрели ресурс или указали причину бана (если вы ее не знаете). Заниматься ли развитием сайта на этом домене — решать вам. Ориентируйтесь на то, что ответит вам техническая поддержка. Часто бывает проще начать все на новом домене.

Отсутствует sitemap

Не самая распространенная причина плохой индексации, но не стоит ее исключать. Создайте карту сайта и не забудьте добавить ее в сервисы для вебмастеров от Google и «Яндекс»:

В «Гугл вебмастер»: