Как проверить индексацию страницы в яндексе, google, bing, mail.ru?

Содержание:

- Что ещё влияет на скорость индексации сайта?

- Почему не индексируется сайт?

- «Яндекс» и Google не знает о вашем сайте

- Сайт или страницы закрыты от индексации в файле robots.txt

- Настройки приватности

- Сайт закрыт от поисковых роботов в мета-тегах

- Ошибки сканирования

- Сайт закрыт от роботов в .htaccess

- Нестабильная работа сервера или хостинга

- Проблемы с индексацией AJAX/JavaScript

- Дубли контента внутри сайта

- Плохая скорость загрузки

- Домен с баном

- Отсутствует sitemap

- Влияет ли название домена и доменная зона на индексацию

- Точный метод

- Проверка индексации страниц сайта через поиск

- Лайфхаки

- Специальные онлайн-сервисы для проверки индексации сайта

- Как сделать так, чтобы Google индексировал обратные ссылки быстрее

- Индексация сайта в поиске

- Типы роботов поисковых систем

- Добавляем сайт в поиск Яндекса

- Проверка индексации с помощью документарных операторов

- Как ускорить индексацию

- Проверить индексацию сайта с помощью сервисов

- Способы проверки индексации сайта

Что ещё влияет на скорость индексации сайта?

Для каждого сайта у поисковика есть свой так называемый краулинговый бюджет. Это число страниц, которые поисковик способен проанализировать за определенное время

Чтобы не тратить бюджет впустую, очень важно сообщить боту, какие страницы нужно сканировать, а какие можно просто пропустить

Правильная настройка файла Robots.txt

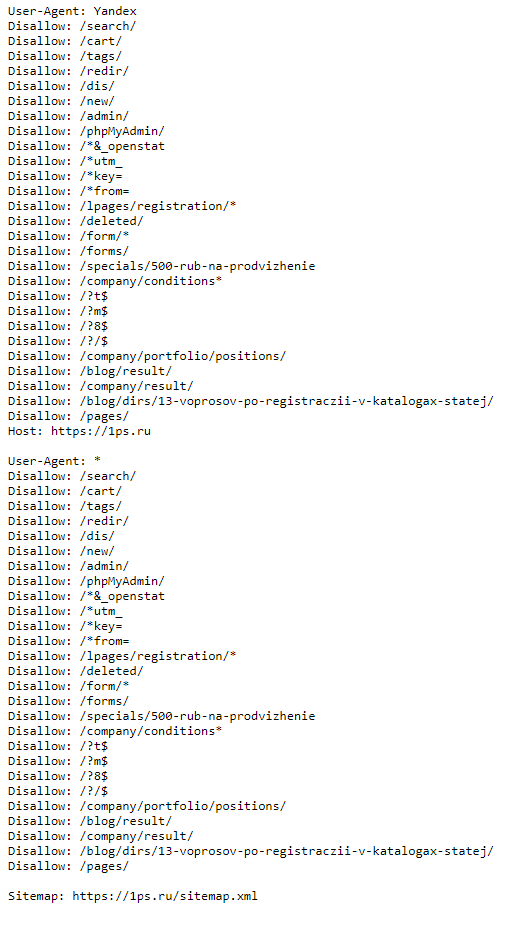

Файл robots.txt — текстовый документ, располагающийся в корне сайта со строгими инструкциями индексации для поисковых ботов.

Файл всегда должен располагаться по адресу адресвашегосайта/robots.txt. К примеру, так выглядит наш файл robots.txt — https://1ps.ru/robots.txt

Файл содержит правила индексации и директивы для поисковых роботов. Какие страницы не следует индексировать, как часто можно индексировать сайт, где располагается карта сайта и т.д. В файле обязательно нужно прописать, какие страницы не следует индексировать. Это все служебные страницы сайта — страница входа в админку, страницы личного кабинета, страница поиска и т.д. Так робот не будет тратить время на индексацию мусорных страниц, не участвующих в продвижении. Подробную статью о том, что скрыть от поисковых роботов, написал мой коллега Дмитрий. Рекомендую к прочтению.

Настройка карты сайта

Карта сайта — отдельная страница либо файл, где перечислены все разделы, подразделы, статьи. Напоминает каталог, в котором зафиксированы все страницы сайта со ссылками на эти самые статьи.

В xml карте сайта должны быть указаны адреса всех страниц, участвующих в продвижении сайта.

Структура сайта. Внутренняя перелинковка

При индексации сайта поисковый бот переходит от страницы к странице, анализируя контент сайта. Наша задача – облегчить маршрут бота, выстилая ему красную дорожку к следующей странице.

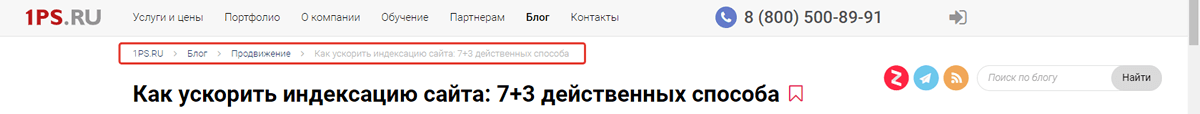

Если вложенность страниц сайта больше двух, обязательно используйте хлебные крошки с микроразметкой. Так боты понимают целостную структуру сайта, что ускоряет индексацию.

Пример хлебных крошек в нашем блоге:

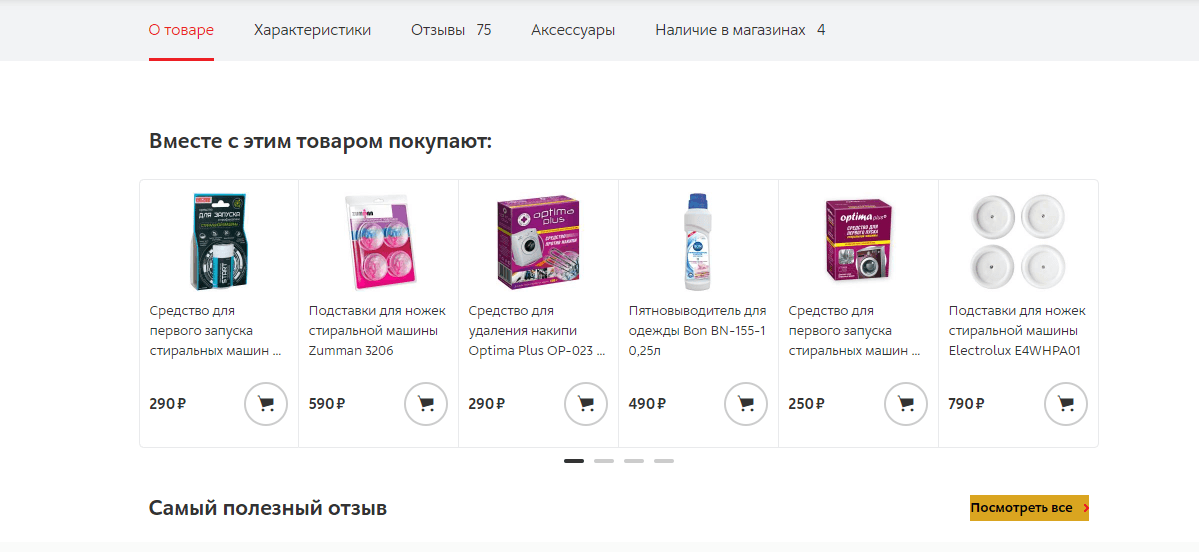

В карточках товаров добавьте раздел «С этим товаром часто ищут» или «Вам может это понравиться» и т.п.

В информационных статьях давайте ссылки на перекрёстные статьи из блога, страницы заказа услуг и т.п. Это увеличит глубину просмотра и упростит индексацию сайта ботам.

Почему не индексируется сайт?

Бывают ситуации, когда вебмастер ведет работу над SEO-оптимизацией сайта: активно наполняет его контентом, наращивает ссылки, а количество страниц в поисковой выдаче Google или «Яндекс» не увеличивается. Или что еще хуже — в поиске нет ни одного документа с сайта. С чем это связано? Самые распространенные причины:

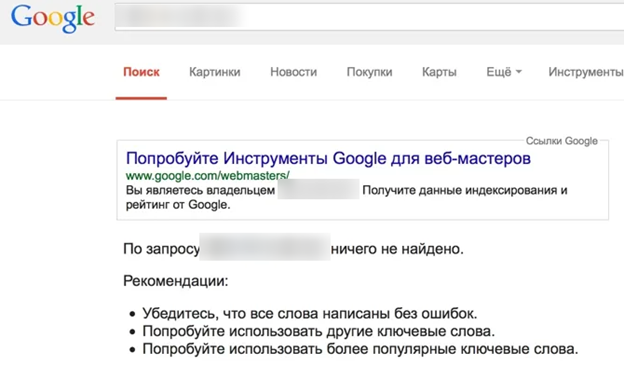

«Яндекс» и Google не знает о вашем сайте

Если это новый ресурс, и вы только недавно открыли его для поисковых роботов, то, возможно, они просто его еще не нашли. Но эту проблему легко решить, выполнив несколько простых манипуляций:

- Добавить сайт в «Яндекс.Вебмастер» и Google Webmasters.

- Направить поисковых роботов на страницы сайта.

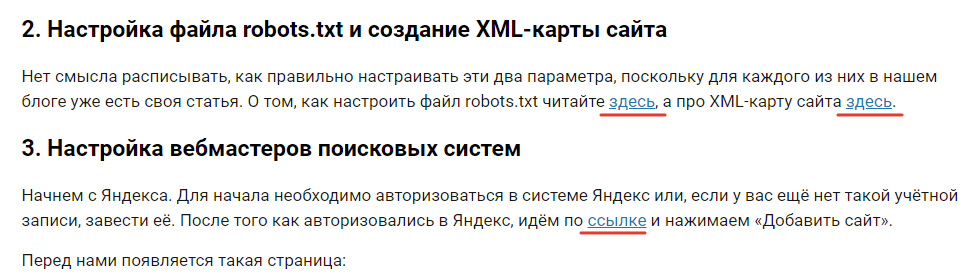

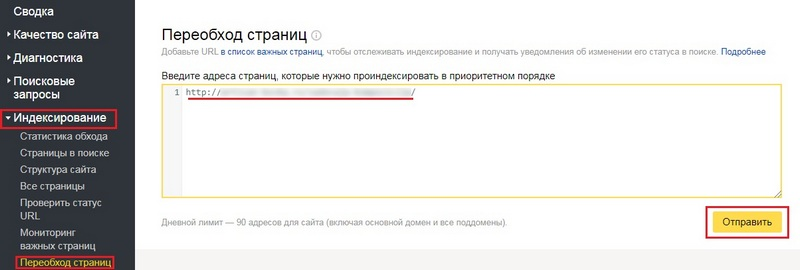

В «Яндекс.Вебмастер» («Индексирование» — «Переобход страниц»):

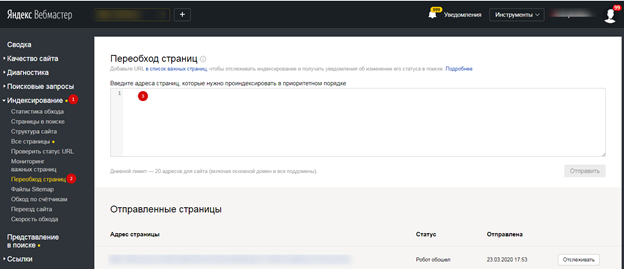

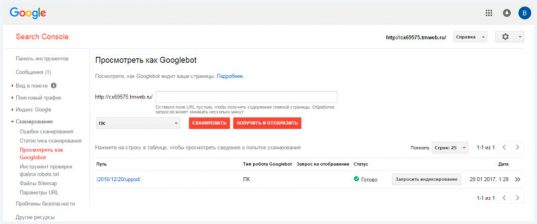

В Google Webmasters («Проверить URL» — Добавить адрес страницы — «Запросить Индексирование»):

Нужно будет немного подождать, пока робот обойдет страницы сайта. Как правило, на это уходит 1-2 часа (хотя может затянуться на несколько дней).

Сайт или страницы закрыты от индексации в файле robots.txt

Порой вебмастера, работая над сайтом, забывают открыть его для индексации. Но это легко исправить. Добавьте следующую команду в файл:

Это означает, что ресурс открыт для всех поисковых роботов. Но не забывайте, что нужно закрыть дубли на сайте, ведь не все содержимое должно принимать участие в поиске. Поэтому уделите заполнению файла robots.txt достаточно времени.

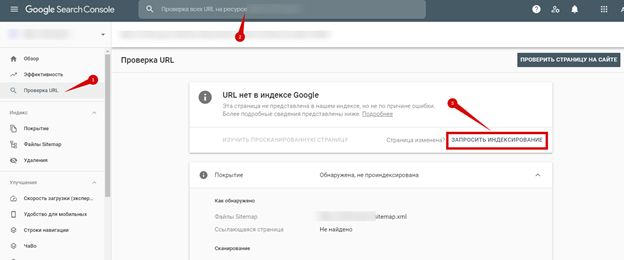

Настройки приватности

Если сайт управляется CMS WordPress, то по умолчанию в нем выставлены настройки приватности, которые запрещают индексацию поисковыми роботами. Авторизуйтесь в админке, перейдите в «Настройки — Чтение — Видимость для поисковых систем» и снимите галочку:

Сайт закрыт от поисковых роботов в мета-тегах

Запретить индексировать содержание страниц можно и с помощью мета-тега:

Как решить проблему:

- Посмотрите, нет ли такого тега на странице.

- Удалите код или добавьте другие мета-теги follow и index.

Ошибки сканирования

Проблемы с индексацией возникают и в том случае, если робот, обращаясь к ресурсу, не может просканировать его содержимое.

Проверьте все ли в порядке:

- Авторизуйтесь в Google Webmaster.

- Откройте «Сканирование» — «Ошибки сканирования»:

В идеале не должно быть никаких ошибок.

Сайт закрыт от роботов в .htaccess

В этом файле содержится правило 301 редиректа. Но помимо него, может быть прописана команда не индексировать сайт.

Чтобы проверить, выполните следующее:

- Найдите и откройте файл файл .htaccess на сервере.

- Проанализируйте содержимое кода.

Нестабильная работа сервера или хостинга

Выбирайте стабильный хостинг с хорошей репутацией. В противном случае, если роботы будут обращаться к сайту, он будет часто недоступен, а их попытки станут все реже. Через некоторое время они и вовсе откажутся заходить к вам на сайт.

Проблемы с индексацией AJAX/JavaScript

Поисковым роботам сложнее просканировать содержимое AJAX и JavaScript, чем HTML. Если вы допустите ошибки при оптимизации, то Google и «Яндекс» не проиндексируют определенные страницы или даже весь сайт.

Дубли контента внутри сайта

За дублирование контента поисковые системы наказывают санкциями, но это тоже одна из причин плохой индексации. К дублям может относиться одинаковый контент, открывающийся на разных страницах, мета-теги или даже страницы, если они доступны под двумя адресами (с www и без; http и https). Если не исправить проблему своевременно, то она негативно скажется на дальнейшем SEO-продвижении.

Плохая скорость загрузки

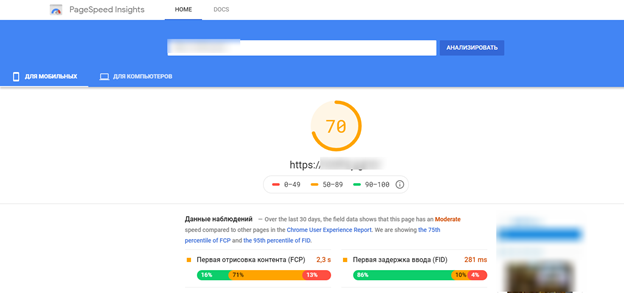

При плохой скорости загрузки ресурса, он может плохо индексироваться и потерять позиции, так как этот показатель относится к факторам ранжирования. Проверить насколько быстро загружается ваш сайт можно с помощью специального инструмента — Google Page Speed:

Поработайте над улучшением скорости загрузки сайта, учитывая рекомендации инструмента.

Домен с баном

Случается, что вебмастер выбирает и регистрирует созвучное имя для сайта, наполняет ресурс и ждет, когда он проиндексируется, но ничего не происходит. После анализа домена, выясняется, что домен ранее использовался и находится в бане поисковых систем.

Исправить такую ситуацию не просто. Придется написать в тех. поддержку «Яндекс», чтобы они пересмотрели ресурс или указали причину бана (если вы ее не знаете). Заниматься ли развитием сайта на этом домене — решать вам. Ориентируйтесь на то, что ответит вам техническая поддержка. Часто бывает проще начать все на новом домене.

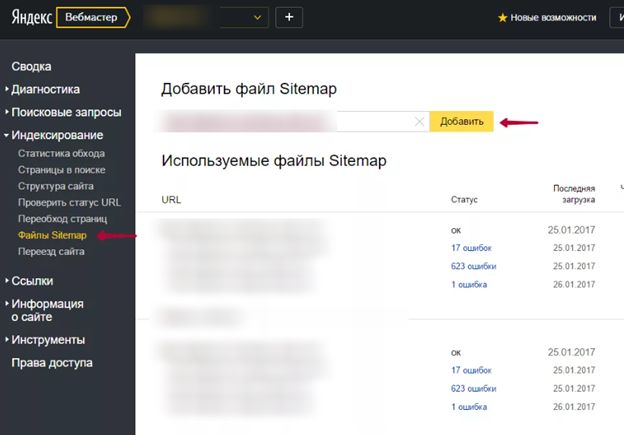

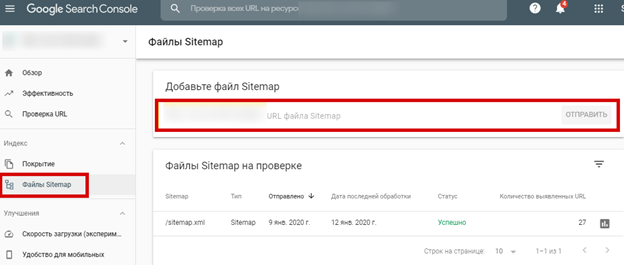

Отсутствует sitemap

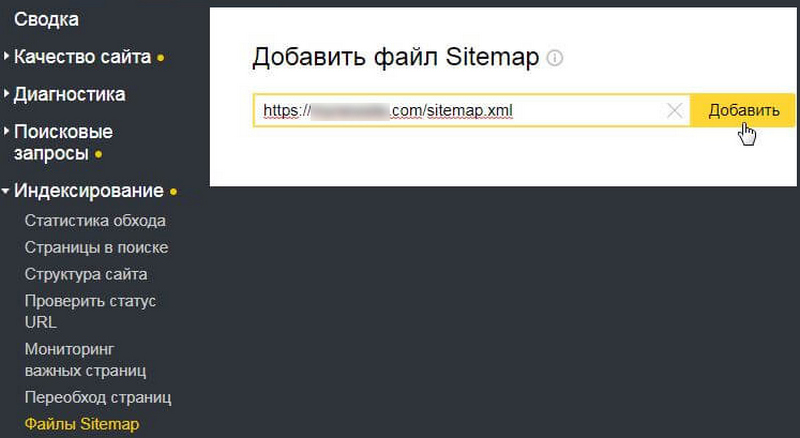

Не самая распространенная причина плохой индексации, но не стоит ее исключать. Создайте карту сайта и не забудьте добавить ее в сервисы для вебмастеров от Google и «Яндекс»:

В «Гугл вебмастер»:

Влияет ли название домена и доменная зона на индексацию

Ответ – нет. На сегодняшний день существуют тысячи различных доменных зон, не только связанных с названиями стран, как это было изначально задумано, но и ассоциирующихся с направлением и деятельностью бизнеса, предметами или событиями.

Есть и популярные в нашей стране кириллические доменные зоны. Когда они появились, были проблемы с их индексацией, но теперь это в прошлом. Однако с кириллическими доменными зонами могут возникнуть иные проблемы, например, ограничения для почты для домена, могут возникнуть проблемы со ссылками, потому что для совместимости домены преобразуются в так называемый punycode (например, домен алаичъ.рф будет выглядеть как xn--80aayk6ds.xn--p1ai), а адреса выглядят совершенно непривлекательно (наверняка вы часто такое видите на Википедии): https://ru.wikipedia.org/wiki/%D0%97%D0%B0%D0%B3%D0%BB%D0%B0%D0%B2%D0%BD%D0%B0%D1%8F_%D1%81%D1%82%D1%80%D0%B0%D0%BD%D0%B8%D1%86%D0%B0

Как бы то ни было, сейчас все это прекрасно будет индексироваться и ранжироваться во всех поисковых системах.

А когда-то проблемы были, я даже пост писал в 2010 году о том, как заставить Rambler индексировать мой блог, который расположен на .info домене. Рамблер не хотел его индексировать 2 года. Хотя чего уж там… самого поиска Рамблера давно уже не существует (имеется в виду, что собственной поисковой системы не существует, а поиск работает на технологиях Яндекса)!

Точный метод

В принципе, конечно, ни Google, ни Yandex – не являются злыми монстрами, которые скрывают информацию от создателей сайта. Они всячески способствуют тому, чтобы проекты были качественными, а потому с радостью предоставляют доступ к различной статистике. В том числе и статистике индексации.

Я уже писал про то, как установить Яндекс Метрику, правда в ней вы найдете информацию о статистике посещений и взаимодействии читателей с проектом. Отношения поисковой системы с вашим сайтом отражается в Яндекс Вебмастер.

Получить доступ к личному кабинету можно точно также, как и в случае с Метрикой. Добавляете сайт, скачиваете файл, который в дальнейшем подтвердит, что вы являетесь владельцем сайта, заходите в личный кабинет хостинга и заливаете его в корневую папку сайта, то есть public_html. Если останутся вопросы – прочитайте статью про Метрику. Действия будут идентичны.

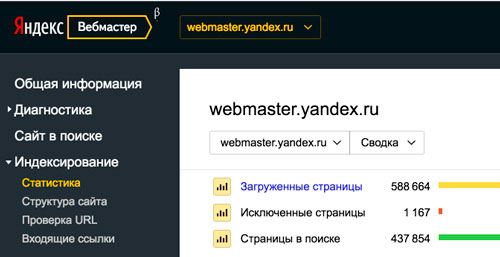

Далее, в разделе индексирование можно посмотреть статистику загруженных и исключенных страниц. Вам предоставляется возможность посмотреть на ошибки и исправить их.

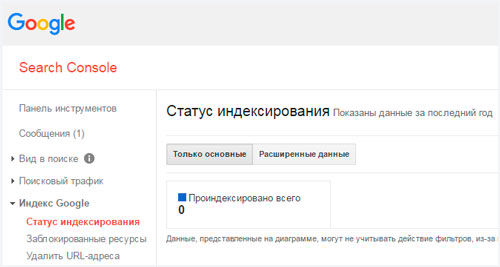

Точно такая же ситуация складывается и с гуглом. Есть Google Analytics, о установке я тоже писал. Там тоже есть доступ ко всем сведениям о количестве посетителей, времени проведения на сайте и так далее, а есть Google Webmaster. Регистрация точно такая же, как и в предыдущих трех случаях. Говорите каким сайтом владеете, скачиваете файл, засовываете его в public_html и готово.

В разделе Индекс Google получаете количество страниц.

Преимущество заключается еще и в том, что вы можете подать запрос на индексацию, тем самым его ускорив.

Эти два метода являются наиболее точными. Помимо индексации эти приложения подскажут о множестве других полезных настроек, так что рекомендую их установить и пользоваться в обязательном порядке.

Проверка индексации страниц сайта через поиск

Термином «индексация сайта» обозначают добавление ресурса или его материалов в базу данных поисковой системы. То есть, если страницы сайта проиндексированы, то при введении поискового запроса они окажутся в общей выдаче. Это именно то, чего добиваются вебмастера – чтобы материалы Интернет-ресурсов как можно быстрее оказались проиндексированы.

Чтобы быть уверенными в том, добавлен ли сайт в поисковую базу, выполняется проверка индексации сайта в Яндексе, Гугле и других поисковых системах. Эту проверку можно выполнять как ручным способом, так и автоматически.

Рассмотрим, как проверить проиндексирован ли сайт, используя при этом поисковый запрос. Здесь возможно несколько вариантов:

- Введение url конкретной страницы в поисковый запрос. Этот способ подойдет для тех страниц, которые проиндексированы не быстроботом Яндекса. В противном случае, страница может и не отобразиться, поэтому данный метод проверки малоэффективный.

- Введение части текста в поисковый запрос. Метод действует только тогда, когда текст уникальный. Для этого необходимо выделить часть текста (10-20 слов) и ввести их в поиск. Однако, материал будет достаточно поздно отображаться в выдаче. Этот способ также не очень эффективный и хлопотный.

- Использование расширенного поиска. Чтобы узнать, проиндексирован ли сайт в Яндексе, нужно ввести необходимый запрос в этом поисковике и выполнить поиск, после чего под строкой появится ссылка «Расширенный поиск». Что касается Гугла, то с ним немного дольше придется повозиться. После введения запроса с правой стороны появится знак шестеренки – «Настройки». Нужно нажать этот значок и в меню выбрать пункт «Расширенный поиск». Помимо Яндекса и Гугла другие ПС также располагают расширенным поиском. Итак, дальше нужно ввести фразу и домен, на котором нужно произвести поиск. В выдаче обычно самой первой должна появиться нужная статья. Это работает при условии, что материал уникальный. Можно пойти более быстрым путем и сразу вбить в расширенный поиск url страницы. Данный способ эффективный, но требует временных затрат. Следует учесть, что не всегда нужный адрес находится на первой позиции в поисковой выдаче. Иногда необходимо просмотреть всю первую страницу в выдаче, то есть, топ-10.

Лайфхаки

Собрали несколько лайфхаков, которые помогают ускорить индексацию обратных ссылок

Больше всего они будут полезны тем, кто занимается линкбилдингом на потоке или продвигает важный проект с расчетом на долгосрочный эффект, не важно занимаетесь вы продвижением сайтов в Google или Яндексе

Можно использовать любой из способов ниже, чтобы ускорить появление бэклинков в выдаче. Некоторые из них не требуют финансовых вложений, а для других понадобится минимальный бюджет.

- 301 редирект. Если есть PBN или несколько заброшенных проектов, можно разместить редиректы со страниц своего проекта на внешние URL, которые надо быстро проиндексировать.

- Массовый AddUrl. Способ используется в связке с предыдущим. После создания страниц, отправьте их на переобход и не забудьте проверить корректность редиректов.

- Публикация ссылок на файлообменниках. Используйте Google Drive, Яндекс.Диск или другие облачные хранилища. Вставьте линки в файл, создайте видео для Youtube, закажите недорогие размещения на Kwork или Fiverr и следите за результатом.

- Яндекс.Браузер. Установите Яндекс. Браузер и расширение Indexer для ускорения индексации в Яндексе.

Последний способ самый простой и бесплатный, но для Google похожего расширения нет. Если хотите использовать его, можно заказать несколько десятков переходов на страницу донора с Google Chrome

Эта активность должна привлечь внимание роботов

Специальные онлайн-сервисы для проверки индексации сайта

Вы можете проверить индексацию сайта, воспользовавшись онлайн-сервисом. Например: AnalizSaita

Для этого вам всего лишь нужно:

- 1.Перейти на сайт сервиса. В поле для ввода вставляем адрес проверяемого сайта и нажимаем на кнопку «Анализ»

- 2.Сервис проведет анализ и отобразит нам результаты по каждой из поисковых систем

Плюсом использования подобных онлайн-сервисов для проверки индексации сайта является то, что вы можете получить данные по индексированию не заходя в Яндекс.Вебмастер или Google Search Console. А так же в том, здесь можно проводить одновременные проверки для нескольких сайтов.

Но с данными сервисами есть свои неудобства. Первый и основной недостаток, на мой взгляд, заключается в том, что вы не сможете здесь получить такой исчерпывающей информации как в Яндекс.Вебмастере.

Второй недостаток заключается в том, что данные сервисы не точно отображают показатели количества проиндексированных страниц.

Перед написанием данной статьи я протестировала несколько из них, и ни один не показал схожие данные с Яндексом или Google.

Надеюсь, моя статья поможет вам проверить индексацию вашего сайта и у вас не возникнет с этим сложностей. На этом у меня на сегодня все. Не забудьте подписаться на рассылку новостей сайта и посетить мой канал на YouTube. До встречи!

С уважением Юлия Гусарь

Как сделать так, чтобы Google индексировал обратные ссылки быстрее

Волшебной кнопки для быстрой индексации в Гугле и других поисковиках не существует. Чтобы нажать её и бэклинки моментально попали в индекс. Но есть рекомендации, которые повышают шансы на успешное индексирование.

Окончательное решение остаётся за алгоритмами. Если они посчитают бэклинк подозрительным или у донора будут активные санкции, ссылки могут не появиться в консолях для вебмастеров.

Убедитесь, что сайт доступен для сканирования

Часто проблемы с индексированием связаны с тем, что роботы не могут получить содержимое страниц. Сайт недоступен из-за плохого хостинга, есть ошибки в конфигурационных файлах или неправильно настроен SEO-плагин.

Самый простой способ проверить доступность для поисковых краулеров — использовать соответствующие инструменты в консолях для вебмастеров. «Переобход» в Яндекс.Вебмастер и «Проверка URL» в Google Search Console.

Добавьте сайт в Google Search Console

Для разбавления ссылочного профиля оптимизаторы часто размещают ссылки не только на старых сайтах, а и на новых проектах. Прежде чем переводить деньги за бэклинк, не забудьте проверить индексацию донора.

Сразу после добавления проекта в GSC, он становится в очередь и через некоторое время роботы обходят страницы. Обычно данные обновляются в течение пары дней, но иногда процесс может занять и недели.

Создайте файл Sitemap

Карта сайта сообщает роботам поисковиков, какие страницы надо обойти. Они считывают дату обновления из файла и понимают, что контент обновился. Если у донора нет карты сайта и новые статьи появляются нечасто, индексация бэклинка может затянуться.

Страница, на которой размещена обратная ссылка, обязательно должна присутствовать в Sitemap. Если вебмастер не следит за этим, проверьте файл и напишите ему с просьбой добавить страницу вручную или обновить список через плагин.

Проверьте robots.txt

Поисковые системы часто игнорируют директивы из технического файла, но иногда страницы с бэклинками не попадают в выдачу из-за ограничений в robots.txt. Гугл и Яндекс давно рекомендуют использовать meta robots, но некоторые вебмастера используют старые методы запрета индексации.

При размещении ссылок на сторонних сайтах доступа к консолям для вебмастеров нет, поэтому для проверки доступности страницы приходится использовать сторонние инструменты. Решить задачу можно с помощью Tools.discript.ru или аналога.

Мониторьте обратные ссылки вручную

При размещении бэклинков через ссылочные биржи можно отслеживать индексацию в одном интерфейсе. Если линк со временем отвалится или выпадет из индекса через несколько дней, можно заказать повторное размещение. Например, при заказе крауд ссылок через нашу биржу Referr, вы сразу в интерфейсе будете видеть новые ссылки и мониторить вручную, чтобы они были доступны.

При работе с вебмастерами напрямую приходится контролировать все самостоятельно. Владелец проекта получает деньги, размещает бэклинк и забывает о вашем существовании.

Усильте ссылки бэклинками

Чем больше упоминаний о важной странице с бэклинком, тем лучше. Тратить много денег на усиление чужого сайта не стоит, но несколько ссылок точно не помешают

В ваших интересах, чтобы инвестиции в линкбилдинг быстрее дали плоды.

Проставляйте линки на свежих страницах

При размещении ссылок через ссылочные биржи вебмастера часто размещают статьи оптимизаторов или заказывают свои. Не секрет, что такой контент очень низкого качества и бэклинки часто вставлены не по смыслу.

Старайтесь подбирать релевантные ресурсы и попросите владельца сайта разместить бэклинк на свежей странице. Или хотя бы немного изменить контент старой статьи и отправить её на переобход.

Проверьте наличие быстробота

У сайтов с новостным контентом и ресурсов, которые обновляются несколько раз в день, обычно нет проблем с индексацией. Ссылки с таких проектов поисковики быстро обнаруживают и если они пройдут проверку, бэклинки появятся в консолях.

Введите адрес сайта в поисковую выдачу, отфильтруйте результаты за день или неделю и посмотрите, как часто появляются новые страницы. Если на сайте есть «прикормленный» быстробот, на нем можно размещаться.

Индексация сайта в поиске

Теперь, когда мы рассказали, что такое индексация, почему она так важна и как её проверить, приступим к практике.

Как ускорить индексацию?

Мы писали выше, что управлять индексацией, что бы кто не говорил, вы не можете. Но повлиять на процесс или даже ускорить возможно.

Советы по ускорению индексации

- Обязательно добавьте сайт во все сервисы Яндекса и Google, особенно в Яндекс Вебмастер и Google Search Console.

- Создайте sitemap.xml, поместите карту в корень сайта и постоянно обновляйте.

- Следите за robots.txt и исключайте ненужные страницы (об этом ниже).

- Выберите надёжный и быстрый хостинг, чтобы робот мог беспрепятственно индексировать содержимое сайта.

- Используйте инструменты Яндекс Вебмастера (Индексирование → Переобход страниц) и Google Search Console (Проверка URL → Запросить индексирование). Способ идеально подходит для работы с отдельными страницами.

- Если ваша CMS любит создавать дубли (например, Битрикс), то используйте атрибут rel=canonical.

- Автоматизируйте создание новых ссылок со старых страниц. Как вариант, можно сделать блок на главной с новыми товарами или статьями.

- Ведите соцсети и анонсируйте новые товары, услуги, страницы. Замечено, что ссылки с соцсетей могут ускорить процесс.

- Создавайте качественный контент на каждой странице. Под качественным контентом мы понимаем актуальную, релевантную и уникальную информацию для пользователей.

- Работайте над структурой сайта и делайте её удобной и понятной пользователю. Помните о правиле 3 кликов: это оптимальное количество действий для пользователя.

- Проверяйте периодически сайт на вирусы и санкции поисковых систем. В Яндекс Вебмастере раздел Диагностика → Безопасность и нарушения, в Google Search Console — раздел Проблемы безопасности и меры, принятые вручную.

- Улучшайте свой ссылочный профиль и пишите анонсы на других сайтах (в рамках правил поисковых систем).

- Используйте родные браузеры (Chrome, Яндекс Браузер) и заходите на новые страницы с них.

Как запретить индексацию?

Выше мы рассмотрели основные способы, как ускорить индексацию, и рассказали, что такое краулинговый бюджет и почему он ограничен для каждого сайта. Поэтому чтобы его не тратить зря, советуем закрывать от индексации служебные и технические страницы, кабинеты пользователей и конфиденциальную информацию, а также страницы в разработке и дубли.

3 основных способа запретить индексацию:

- Директива Disallow в файле robots. Мы писали, что такой запрет может не сработать в отдельных случаях. Тем не менее это основной способ запрета индексации.

- В коде страницы указать метатег robots с директивой noindex (для текста) и/или nofollow (для ссылок). Хорошо подходит для запрета индексации отдельных страниц.

- Настроить HTTP-заголовок X-Robots-Tag с директивой noindex и/или nofollow. Лучше всего подходит для закрытия индексации не HTML-файлов (PDF, изображения, видео и другие).

Используйте все наши советы по улучшению индексации на полную мощь.

Максимальное внимание уделите улучшению структуры и навигации и обновлению карты сайта.

Структура сайта должна быть проста и понятна, охватывать весь спектр ключевых запросов, а каждая страница сайта в идеале должна быть доступна в 3–4 клика

Для этого используйте дополнительные блоки на главной странице и в разделах.

Хорошо работает облако тегов: с помощью него часто получается продвигать категории, улучшать навигацию и полно охватывать семантику.

Для многостраничных сайтов действительно важно постоянно обновлять sitemap.xml

Зачастую в таких случаях карту делят на несколько частей, чтобы охватить весь список страниц.

Настройте маски (автоматические шаблоны) метатегов для новых страниц в категориях и каталогах.

Скорее всего, вам не обойтись без команды профессионалов, которые смогут обеспечить техподдержку, производство контента и SEO-продвижение.

Типы роботов поисковых систем

Процессы поисковых систем основаны на работе четырех типов основных поисковых роботов:

- Основной индексирующий робот;

- Робот, индексирующий изображения;

- Робот, изучающий зеркала сайта;

- Робот, контролирующий работоспособность страниц сайта и сайта в целом.

Вы можете контролировать, вернее, быть в курсе, какой робот зашел к вам на сайт. Для этого есть специальные лог-файлы посещений. Доступны эти файлы в административной панели сервера (хостинга) или по FTP. Например,

- Основной индексирующий робот Яндекс: YandexBot/3.0; +http://yandex.com/bots;

- Бот Mail: Mail.RU_Bot/2.0; +http://go.mail.ru/help/robots.

- В журнале посещений, вы увидите боты в таком обозначении: «Mozilla/5.0 (compatible; bingbot/2.0; +http://www.bing.com/bingbot.htm) – это бот Bing.

Кроме четырех перечисленных , выше, типов роботов, есть и другие индексирующие роботы:

- Индексирующие видео и иконки (пиктограммы) сайтов;

- Робот, контролирующий доступность (работоспособность) сайтов;

- Индексатор «быстрой» информации, на новостных площадках Яндекс. Новостей и т.п.

На этом все! Эта небольшая статья, не может охватить все детали, и процессы поисковых систем требует более глубокого изучения.

SeoJus.ru

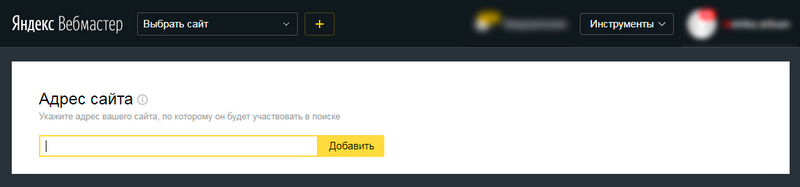

Добавляем сайт в поиск Яндекса

Чтобы страницы нового сайта начали отображаться в поиске Яндекса их также нужно добавить в индекс. Механика процесса идентична поисковой системе Google. Добавление ресурса в поиск осуществляют через консоль Яндекс.Вебмастер. При этом есть и другие способы (о них мы расскажем ниже), но наиболее рабочим считается именно этот. Возможности вебмастерки Яндекса в целом аналогичны Search Console. Более подробно об этом сервисе можно почитать здесь.

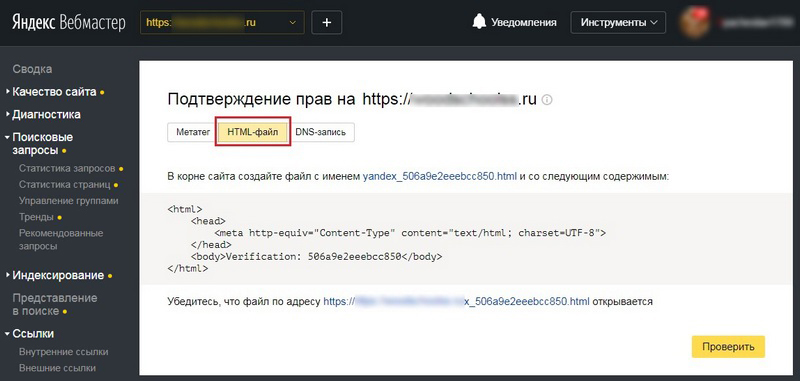

Добавление в Яндекс.Вебмастер и подтверждение прав на сайт

Для привязки сайта к вебмастерке понадобится учетная запись в Яндексе. Если она есть, что вероятнее всего, т.к. многие пользуются почтой и другими яндексовскими сервисами, переходим сюда и указываем адрес сайта.

Как и в случае с гугловской консолью, дальше нужно пройти верификацию и подтвердить права. Сделать это можно по-разному:

- создав HTML-файл с уникальным идентификатором, и поместив его в корневой каталог сайта;

- разместив в HTML-коде главной страницы специальный метатег;

- добавив DNS-запись с идентификатором;

- подтвердив электронный адрес из WHOIS-записи (этот способ не рекомендуется даже самим Яндексом).

Для подтверждения прав удобнее всего использовать первый способ — через HTML-файл. Указав сайт и перейдя во вкладку, отмеченную на скриншоте, система сгенерирует файл с уникальным именем и содержимым. Его нужно скачать и разместить в корневом каталоге сайта. Далее проверяем, что файл открывается по указанной ссылке. Нажимаем кнопку «Проверить». Если все сделано правильно, панель инструментов слева станет кликабельной.

Добавляем сайт в индекс

После верификации и получения доступа к функционалу вебмастерки, выполняем следующие действия.

Переходим во вкладку «Индексирование» → «Переобход страниц»

Добавляем главную страницу и основные разделы сайта — нажимаем «Отправить»

Обратите внимание, в Яндексе установлен лимит на количество индексируемых страниц

Все новые страницы, которые в дальнейшем будут добавляться на сайт, отправляют на переиндексацию по аналогичной схеме.

Дополнительно в Яндекс.Вебмастер необходимо добавить файл sitemap.xml. Здесь работает та же механика, что и в Google. Сначала необходимо создать саму карту. Если это сделано не через плагин — размещаем sitemap на сервере. Далее в разделе «Индексирование» → Файлы Sitemap вписываем в поле URL, по которому доступен файл. Нажимаем «Добавить».

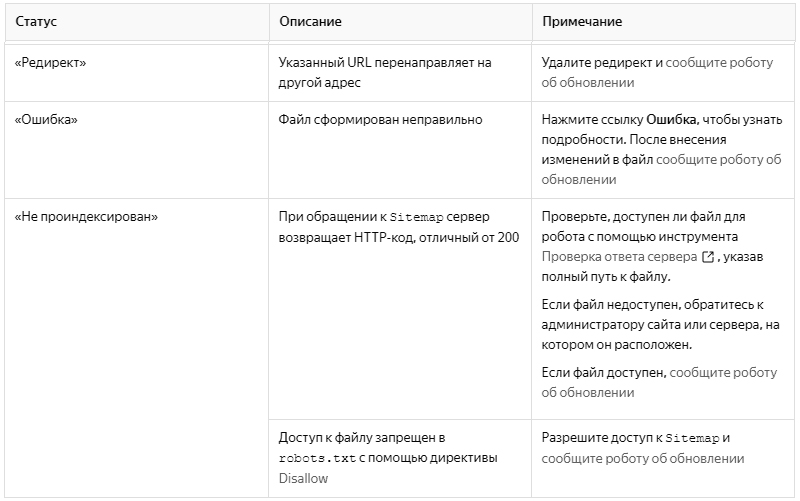

После добавления файл будет какое-то время обрабатываться. Это происходит не быстро, и может занять до двух недель. По завершении обработки напротив файлов должен отображаться статус «OK». Если присутствует статус «Редирект», «Ошибка» или «Не проиндексирован», необходимо определить причину некорректной индексации, исправить ее, после чего сообщить роботам об обновлении.

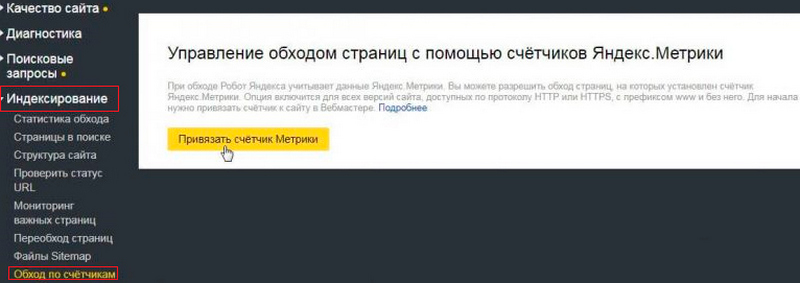

Индексируем страницы через Яндекс.Метрику

Существует еще один способ сообщить краулерам Яндекса о новых страницах сайта — через Метрику. Этот вариант менее удобен, чем первый, но знать о нем вебмастеру не помешает. Для этого на сайте должен быть добавлен и настроен счетчик Яндекс.Метрики. В любом случае рано или поздно его придется добавить, конечно, если вы намерены серьезно заниматься продвижением своего проекта.

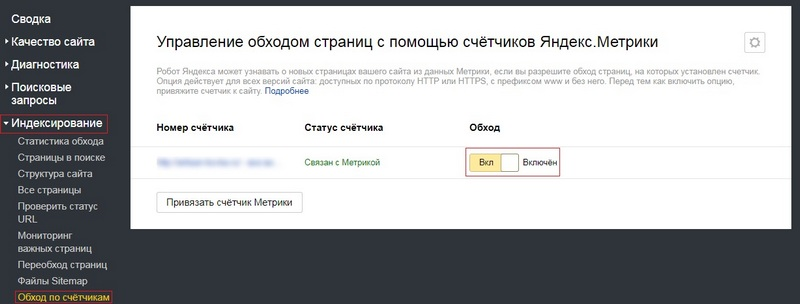

Итак, чтобы роботы Яндекса подтягивали сведения о новых страницах из данных Метрики, нужно разрешить обход страниц, на которых установлен счетчик. Для этого выполняем следующие действия.

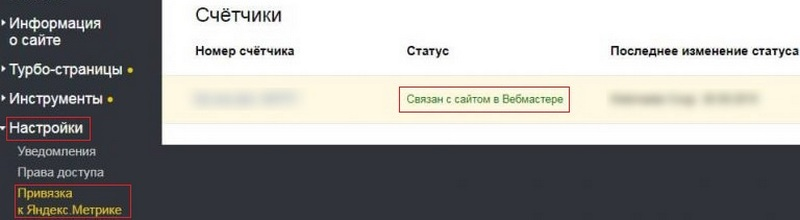

Активировав эту опцию, во вкладке Привязка к Яндекс.Метрике отобразится статус «Связан с сайтом в Вебмастере».

Проверка индексации с помощью документарных операторов

Попавшие в индекс страницы можно увидеть, применив документарный оператор «Site:». Вбейте его в поисковую строку и укажите полный адрес.

Пример для Google:

Проиндексировано около 294 000 страниц. Сопоставив эту цифру с их количеством на сайте, можно приблизительно оценить полноту индексации. Небольшие расхождения могут быть по причине того, что часть новых страниц еще не проиндексированы и находится на рассмотрении поисковых роботов. Большие расхождения говорят об ошибках. Если при периодической проверке расхождение увеличивается, возможны проблемы с индексацией.

У Google есть дополнительные инструменты для более глубокого анализа. Например, можно посмотреть сколько появилось в индексе новых страниц за определенный период времени.

Пример для Яндекс:

Использование операторов дает лишь приблизительное представление о проверке индексации. Хорошо, если количество страниц у Google и Яндекс совпадают между собой. Если нет, как на скринах выше, нужно искать причины расхождений. Например, есть внутренние ошибки, которые влияют на индексацию в поисковых системах.

Как ускорить индексацию

От скорости индексации зависит то, насколько быстро на страницах появится трафик

Это особенно важно для новостных ресурсов, которые должны индексироваться моментально, чтобы получить переходы из ПС. Иначе теряется актуальность их материалов

Существует несколько простых способов заставить роботов чаще посещать ваш сайт:

- Добавьте ресурс в сервисы инструментов для вебмастеров Гугл и Яндекс.

- Регулярно добавляйте новые материалы на сайт (чем чаще, тем лучше).

- Проработайте удобную навигацию (в идеале, чтобы страницы имели вложенность не больше, чем три клика от главной).

- Выберите хороший хостинг, который не будет давать сбоев в работе сайта.

- Закрыть от индексации ненужные страницы в robots.txt.

- Перелинковать страницы между собой (удобно и для пользователей, и для ботов).

- Нарастить ссылки из соцсетей.

- Создать карту сайта в двух вариантах — .xml и .html.

Проверить индексацию сайта с помощью сервисов

Таких сервисов очень много. Я покажу вам два.

Serphunt

Serphunt – онлайн-сервис для анализа сайта. У них есть полезный инструмент для проверки индексации страниц.

Одновременно можно проверить до 100 страниц сайта по двум поисковикам – Яндекс и Google.

Чтобы проверить индексацию страницы внесите её в список:

Нажимаем «Начать проверку» и через несколько секунд получаем результат:

Netpeak Spider

На мой взгляд хороший сервис для анализа сайта – это Netpeak Spider. Тем более на момент написания статьи там 14-дневная бесплатная версия.

Помимо индексации сайта, можно проверить гору других данных:

- битые ссылки;

- внутренние и внешние ссылки;

- коды ответа;

- мета-теги;

- файл robots.txt;

- ошибки и прочее.

Способы проверки индексации сайта

Предлагаем вашему вниманию 4 самых распространенных и простых способа, позволяющие проверить, какие страницы есть в индексе, а какие – нет.

1. Через панель вебмастера

Этим методом владельцы веб-ресурсов проверяют их наличие в поиске чаще всего.

Яндекс

- Авторизуйтесь в Яндекс.Вебмастер.

- Перейдите в меню «Индексирование сайта».

- Под ним найдите строку «Страницы в поиске».

Можно пойти и по другому пути:

- Выберите «Индексирование сайта».

- Дальше перейдите в «История».

- Затем кликните на вкладку «Страницы в поиске».

И первым, и вторым способом вы сможете изучить динамику роста или спада числа страниц в поисковой системе.

- Зайдите в панель управления сервиса .

- Кликните на вкладку Search Console.

- Перейдите в «Индекс Google».

- Нажмите на опцию «Статус индексирования».

2. Через операторов поисковых систем

Они помогают уточнить результаты поиска. Так, применение оператора «site» позволяет увидеть приблизительное число страниц, которые уже находятся в индексе. Чтобы проверить этот параметр, в строке поиска Яндекс либо Google укажите: «site:адрес_вашего_сайта».

Важно! Если результаты в Google и Яндекс сильно разнятся между собой, то значит ваш сайт имеет какие-то проблемы со структурой сайта, мусорными страницы, индексацией или на него наложены санкции. Для поиска вы также можете использовать дополнительные инструменты, например, чтобы узнать, как изменялась индексация страниц за определенный период времени

Для этого под поисковой строкой нажмите на вкладку «Инструменты поиска» и выберите период, к примеру, «За 24 часа»

Для поиска вы также можете использовать дополнительные инструменты, например, чтобы узнать, как изменялась индексация страниц за определенный период времени. Для этого под поисковой строкой нажмите на вкладку «Инструменты поиска» и выберите период, к примеру, «За 24 часа».

3. Посредством плагинов и расширений

Используя специальные программы, проверка индексации веб-ресурса произойдет автоматически. Это можно сделать с помощью плагинов и расширений, еще известных как букмарклеты. Они представляют собой javascript-программы, которые сохраняются в браузере в виде стандартных закладок.

Преимущество плагинов и расширений в том, что вебмастеру нет необходимости каждый раз по новой заходить в поисковик и вводить там адреса сайтов, операторы и прочее. Скрипты произведут все в автоматическом режиме.

Самым популярным плагином, применяемым в этих целях, является RDS bar, который можно скачать в магазине приложений любого браузера.

Стоит отметить, что в Mozilla Firefox у плагина куда больше возможностей, чем в других браузерах. RDS bar предоставляет информацию относительно и всего веб-сайта, и его отдельных страниц

На заметку. Есть платные и бесплатные плагины. И самый большой минус бесплатных плагинов в том, что в них регулярно нужно вводить капчу.

Нельзя оставить без внимания и букмарклет «Проверка индексации». Чтобы включить программу, просто перетяните ссылку на панель браузера, а затем запустите свой портал и нажмите на закладку расширения. Так вы откроете новую вкладку с Яндекс или Google, где изучите нужную информацию касательно индексации определенных страниц.

4. С помощью специальных сервисов

Я в основном пользуюсь сторонними сервисами, потому что в них наглядно видно какие страницы в индексе, а какие там отсутствуют.

Бесплатный сервис

https://serphunt.ru/indexing/ — есть проверка, как по Яндекс, так и по Google. Бесплатно можно проверить до 50 страниц в сутки.

Платный сервис

Из платных мне больше всего нравится Topvisor — стоимость 0.024р. за проверку одной страницы.

Вы загружаете в сервис все страницы вашего сайта и он вам покажет, какие находятся в индексе поисковых систем, а какие нет.